こんにちは!じゅりんHACK管理人のじゅりんです。

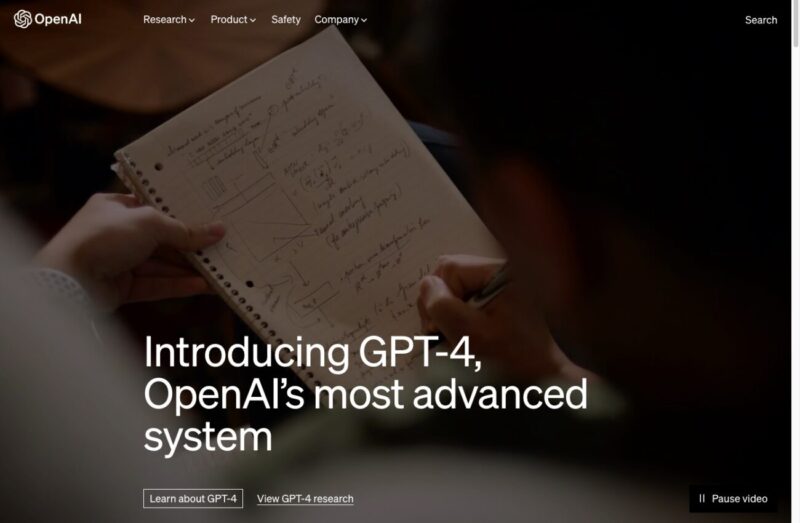

ついに!OpenAIが3月14日に「GPT-4」を発表しました!

今の時点でも「ChatGPT」が世界の産業を大きく塗り替えると言われるほどの衝撃でしたが、ChatGPTで使われている「GPT-3.5」よりもさらに強力に賢くなったAIが「GPT-4」。

これはもうどうなってしまうのか?ワクワクが止まりません。

そんなわけで、今回は「GPT-4」にできるようになったこと、そして「GPT-4」を使うにはどうすればいいかについて解説しました!

ここがスゴいよ!「GPT-4」!

↑「GPT-4」について、OpenAIが公開した動画がこちらです。

動画の内容を要約すると

GPT-4は、最大で25,000語のテキストを生成し、画像を理解することができる高度で洗練された言語モデルです。完璧ではないものの、特に教育分野において、人間の能力を強化する可能性があります。OpenAIは、技術をより安全で適切にするために取り組んでおり、最終的にはより良い生活の質につながることを期待しています。 GPT-4は、高度で能力のあるAIシステムとして世界で初めての経験になると考えられており、早期採用者や技術に詳しい人たちだけでなく、誰にとっても役立つものになるようにすることがOpenAIにとって重要です。

動画の書き起こしをChatGPTにて要約

このようになります。

公式サイトと併せて、「GPT-4」の特徴的なところを見ていくと…

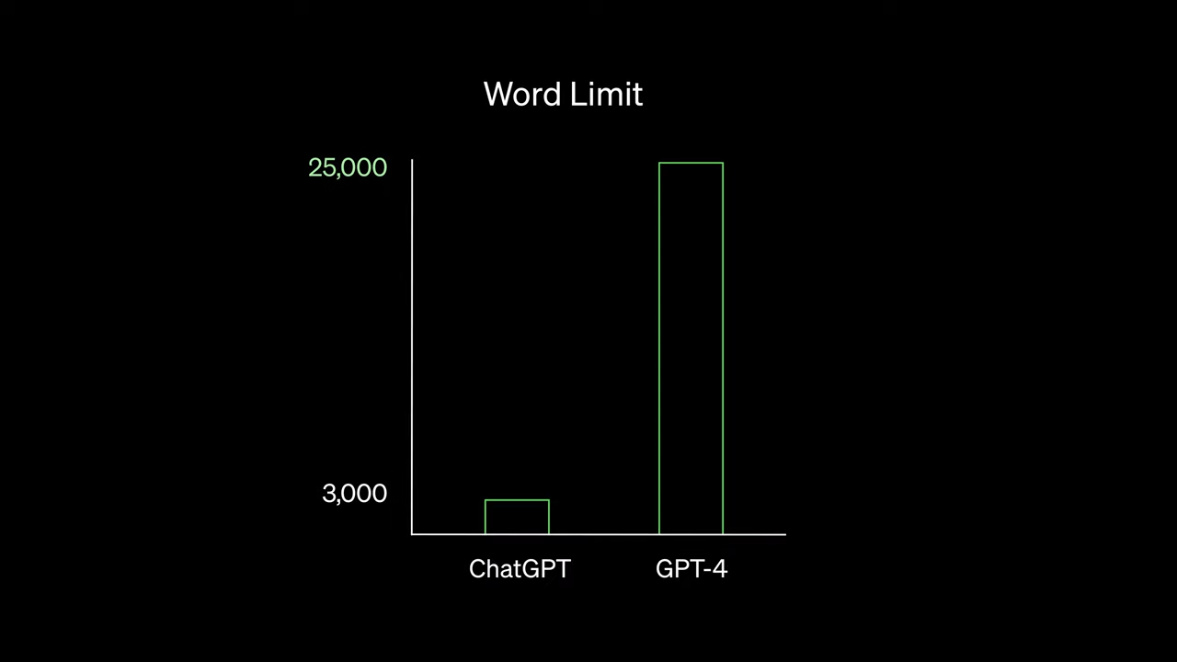

「GPT-4」は、一度に扱える(入出力できる)文字数が25,000と大幅アップ!

「GPT-4」は、一度に扱える(入出力可能)な文字量が25,000と、「ChatGPT」の3,000文字から大幅にアップ

「GPT-4」では、これまでの「ChatGPT」では処理できなかった長文の要約や、中・長編小説やレポートなどの執筆、プログラミングのコード生成なども、分割せずに一気に行えるようになります。

これはさらに仕事に活用できますね!!これまでの処理できる文字数制限は何気にストレスになっていたので。

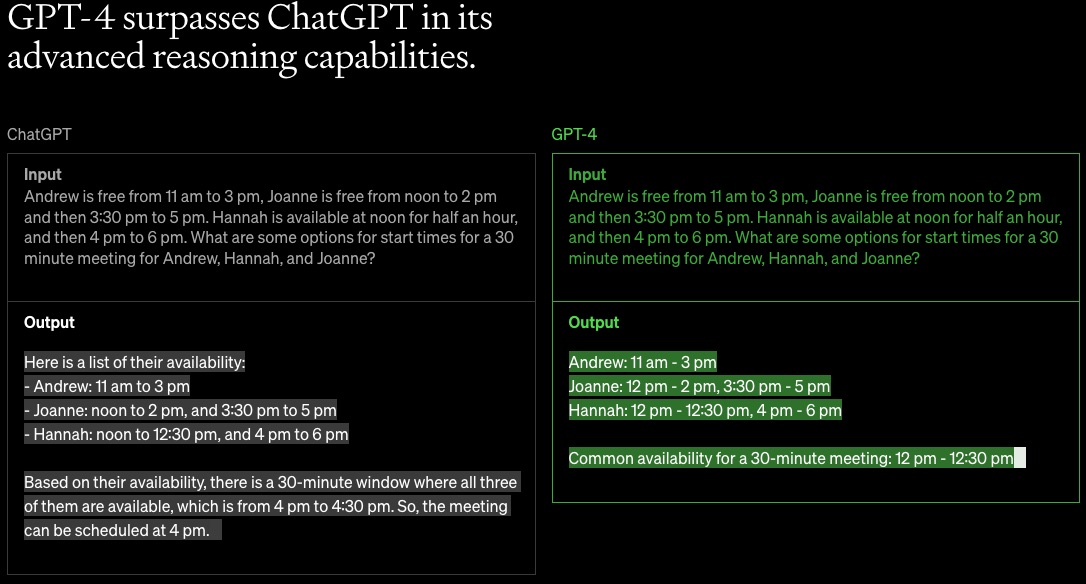

「GPT-4」の推論能力は「ChatGPT」よりも高い!

もちろん扱える文字数が増えただけではありません。

いわゆる頭の良さも「GPT-4」は従来の「ChatGPT」を上回ります。

例えば上の画像だと、【3人の空いているスケジュールを示した上で、3人全員が30分間ミーティングできる時間(開始時間)を教えて】という指示を投げかけています。

「ChatGPT」は回答を間違っていますが、「GPT-4」は正しく回答してくれています。

このように推論、分析、表現能力、クリエイティビティにおいても、「GPT-4」は「ChatGPT」を上回っているとのことです。

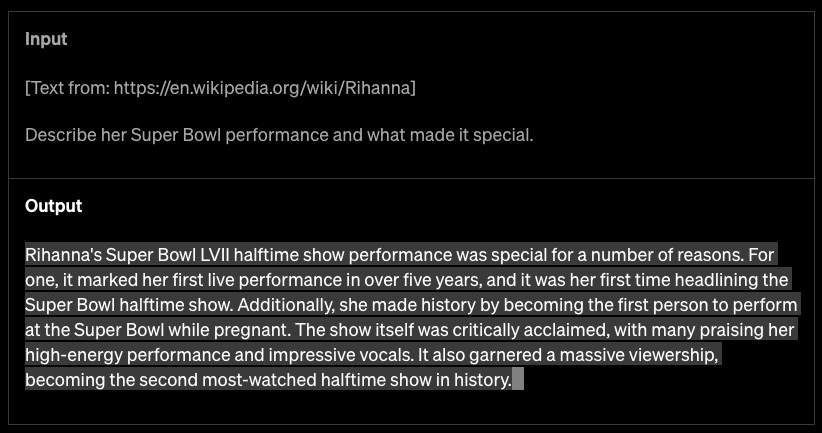

「GPT-4」は、URLを読み込める?

「GPT-4」の公式サイトで見つけたこの事例、「URLから他サイトの情報を読み込ませる」ことができるように見えます。例えば、上の事例のように「Wikipediaの長文をリンク先から読み込ませて、要約させる」なんてことも可能になるのかも?

これ、本当にできるのならめっちゃ嬉しい!!

サイトの分析や要約をするのにめちゃくちゃ役立ちそうです!!(「ChatGPT Plus」でできるのかは不明です)

「GPT-4」は、画像を意味のある情報として捉えて推論できる!

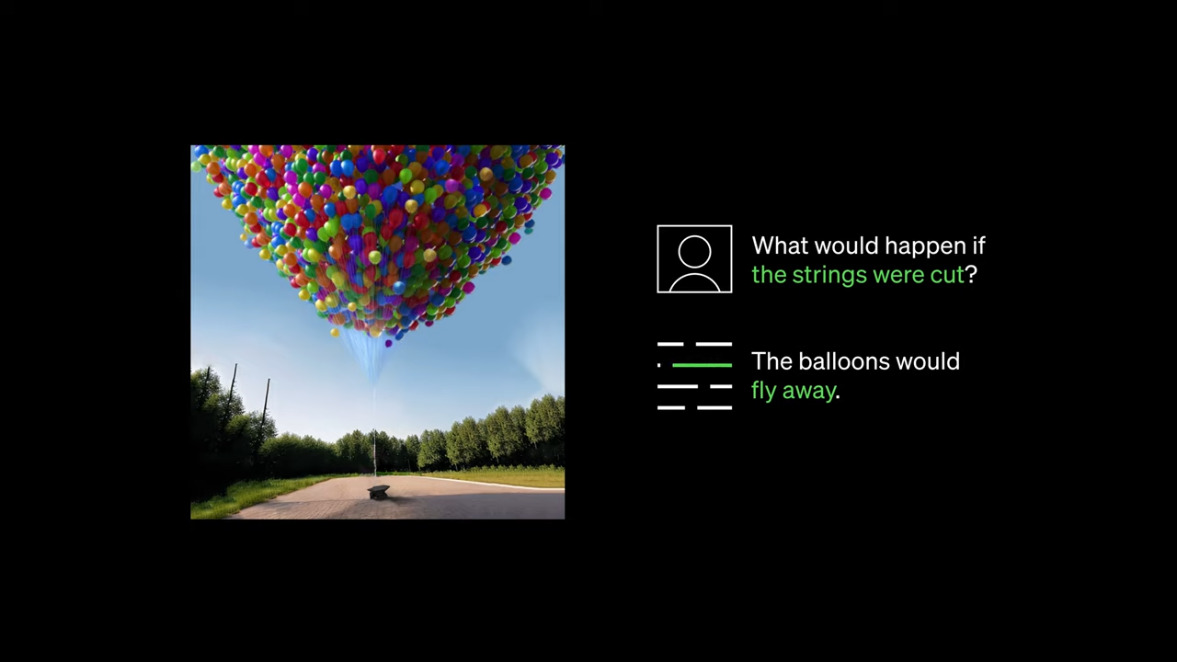

さらに「GPT-4」は、画像から推論できることを答えられるようになりました。

例えば、動画で紹介されているのが、こちら。「風船が浮かんでいる画像」を「GPT-4」に渡した後、「この糸を切るとどうなりますか?」と質問すると、「GPT-4」は「風船は飛んでいきます」と返答します。

つまり、画像の中にある事象を判断して、何が起こるのかを推論する能力まで備えているというのです。

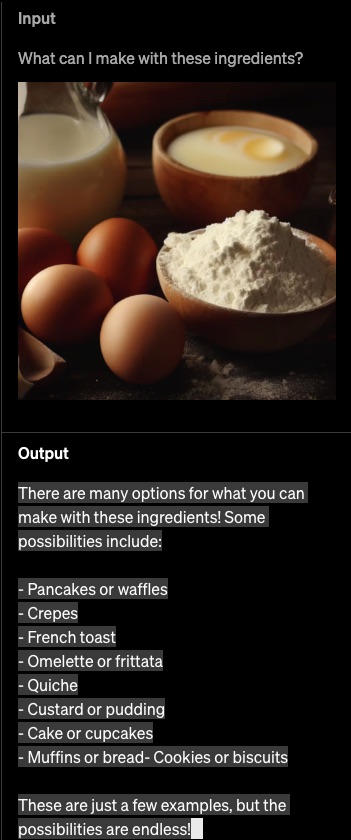

こちらの事例では、「これらの材料から何が作れますか?」と食材の写真を「GPT-4」に渡しただけで、「パンケーキやワッフル」「クレープ」「フレンチトースト」…などの答えを返してくれています。

これまでの「ChatGPT」だと、冷蔵庫の中身をテキストで入力して「これでできる料理を考えて」とかが話題になっていましたが、もはや画像一枚で材料の説明がつくんですね!!

とんでもないな!「GPT-4」!

もはやAIにとって画像とは単なるデータの塊ではなく、意味のある情報として処理されているんですね。Googleフォトなんかも画像の中の人やモノを判別していますが、「GPT-4」はさらにそこから一歩進んで、画像の未来や過去の影響や現象まで返答してくれるということ。スゴすぎる!!

こうなるともはやテキストで説明することさえ最小限で済むようになるのかもしれません。

これはあくまでぼくの勝手な想像ですが、実在する建築物の写真を「GPT-4」に渡して、「この建築物の構造上の課題を教えて」とか「この建築物のデザイン上の改善点を教えて」とか聞けば教えてくれる可能性だってあるのかも?活用しどころが多すぎて興奮しちゃいますね!!

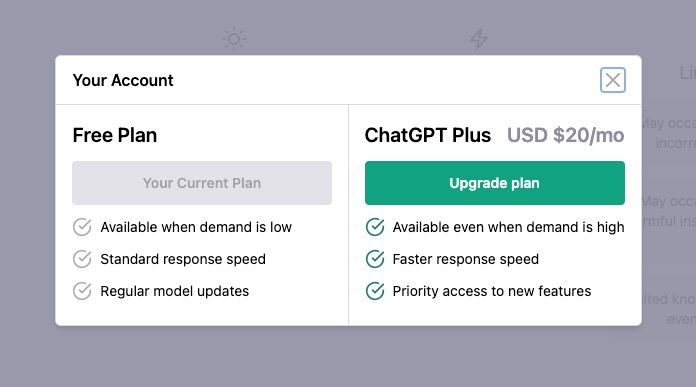

「GPT-4」は「ChatGPT-Plus(有料版)」で使えるようになります

「GPT-4」は「ChatGPT Plus(有料版)」で早速使えるようになります

そんな物凄い能力を持った「GPT-4」。

実は、「ChatGPT」で使えるようになりました。

正確には「ChatGPT Plus」という有料版の方で先行して使えるようになったという状態です。「ChatGPT Plus」は月額20ドル(約2,400円)ですが、いち早くこの超性能を実感したい方にとっては決して高い金額ではないはず。

ただし、有料版だからといって完全に自由に使えるというわけではなく、文字数的なことや時間的な制限はあるようです。これは公開したばかりだから仕方がないですね。

おそらく徐々に制限は緩和されていくでしょうし、もしかしたら今後無料版の「ChatGPT」でも「GPT-4」が使えるようになるのかもしれません(あくまで推測です)。

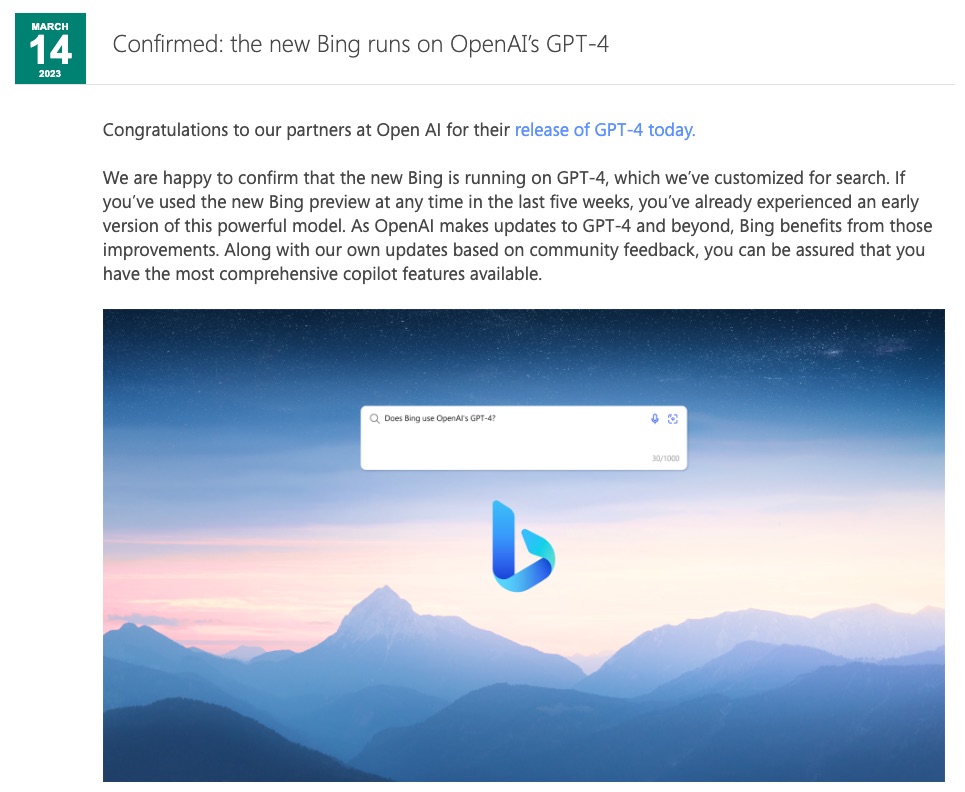

Microsoftの「BingAI」も「GPT-4」の初期バージョンを使用

あとは、他に「GPT-4」の能力の一端を味わうには、Microsoft製の「BingAI」を使ってみることです。

こちらは、「ウィッシュリスト(順番待ち)」に登録する必要がありますが、無料で使えます。

このBingAIは「GPT-4」の初期バージョンで動作していたとMicrosoftが同日(3/14)発表していて、今回発表された正式版の「GPT-4」には及ばないかもしれませんが、それでもかなり高性能なAIとのやり取りを楽しむことができます(検索用にチューニングされているそうです)。

実際にぼくもBingAI使えるようになりましたが、ChatGPTとはまた違った形でとても優秀だと感じています。

まとめ|楽しみすぎてヤバい「GPT-4」!想像を上回る未来がすぐそこまで来ています!

いかがでしたでしょうか?

ついに発表された「GPT-4」。…とは言っても、昨年11月に「ChatGPT」が発表されてからまだ半年も経っていないんですよね。とんでもない速さでチャット型AIが急速に進化しています。

人間の方が取り残されてしまいそうなほどのスピード感ですが、なんとか食らいついてこの面白すぎるAIを使い慣らしていきたいものですね。

とりあえず「GPT-4」…「ChatGPT」を有料版にしてでも使っちゃおうかな〜と、スゴい誘惑に駆られています!!